AMD发布全新AI加速卡InstinctMI350系列:288GBHBM3E海量内存、1400W功耗野兽

2023年发布的Instinct MI300X,可以说是AMD最成功的AI GPU加速卡,甚至称得上AMD历史上最成功的产品之一,用最快的速度拿到了1亿美元收入。

更重大的意义在于,它在几乎被NVIDIA完全垄断的高端AI芯片市场上,撕开了一道口子,为行业提供了更多选择。

2024年,AMD再接再厉发布了升级版的Instinct MI325X,主要提升了HBM3E内存,核心规格没变。

无论性能还是技术特性,新卡都再次取得了长足的进步,完全可以和NVIDIA Blackwell系列掰一掰手腕。

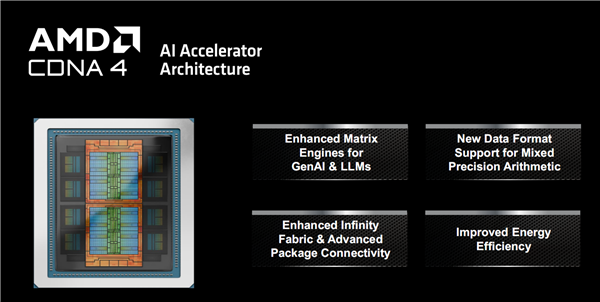

MI350系列最核心的变化,就是升级了新一代CDNA 4架构(可能也是最后一代CDNA),同时采用了新的N3P工艺。

从大的方向上讲,这一代的提升主要有四个方面,首要的自然是更好的AI能力,针对生成式AI和LLM大语言模型增强了数学矩阵模型。

另外,支持新的混合精度数据格式、增强Infinity Fabric互连总线和高级封装互连、改进能效,也都是重中之重。

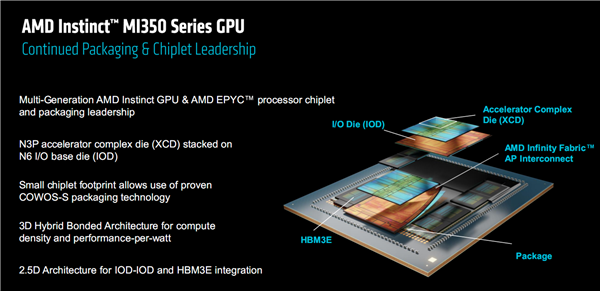

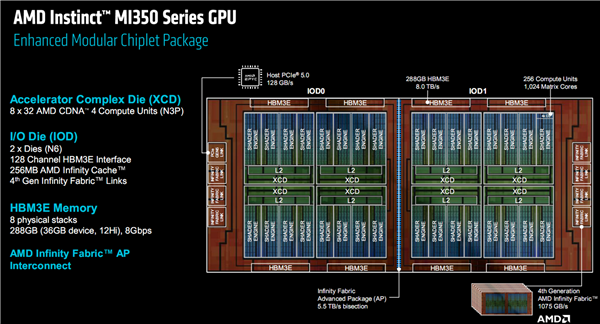

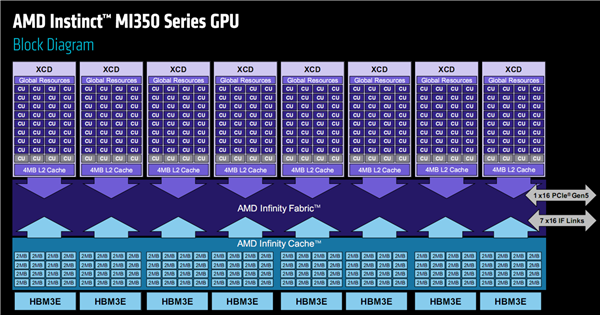

MI350系列继续采用延续多代的chiplets芯粒设计,仍然分为顶层的XCD(加速器计算模块)、底部的IOD(输入输出模块)和周围的HBM3E内存模块。

其中,XCD工艺从5nm升级为N3P 3nm级工艺高性能版本,IOD则维持在6nm工艺。

它采用了非常复杂的多重先进封装技术,不同模块之间使用了2.5D、3D混合键合,整体则用了台积电的CoWoS-S晶圆级封装,使用硅中介层作为主要的连接媒介NVIDIA也在大面积使用它,不过已经开始向更高级的CoWoS-L过渡。

上代MI300X就使用了1530亿个晶体管,创下新高,mile米乐m6MI350系列进一步增加到1850亿个晶体管。

XCD模块一共有8个,每个内部分为4组着色器引擎,下辖36组CU计算单元,还有4MB二级缓存,配有一个全局资源调度分配单元。

整体合计288个CU单元、32MB二级缓存,但是MI350系列每个XCD中屏蔽了4组CU单元,实际开启了256组(1024个矩阵核心),反而少于MI300X/MI325X 304组(另屏蔽16组),而每个单元的二级缓存容量没变。

HBM3E内存仍然是8颗,每一颗都是12Hi堆叠,和MI325X相同而高于MI300X 8Hi,只是这次开放了全部容量,单颗是完整的36GB而非32GB,因此总计多达288GB。

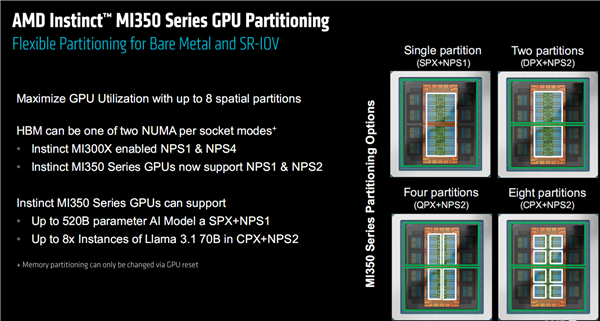

在裸金属、SR-IOV虚拟化应用中,为了实现最大化利用,MI350系列支持对计算资源进行空域分区,最多可以分成8个。

不同分区可以支持多种使用模式,但不同于前代的NSP1、NSP4,这次改为NSP1(单个分区)、NSP2(双/四/八个分区),看似降级了,AMD解释说NSP4模式的性能提升其实比较有限。

MI350系列在单分区+NSP1模式下,最高可以支持5200亿参数的AI模型,而在八分区+NSP2模式下,可以支持最多8个700亿参数Llama 3.1模型的并发。

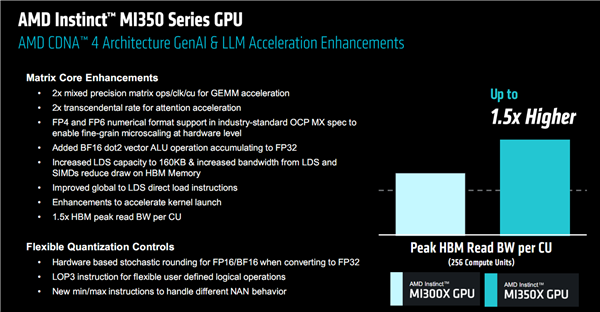

MI350系列针对生成式AI、LLM的具体改进,包括矩阵核心的提升和更灵活的量化机制,过于专业就不一一解释了。

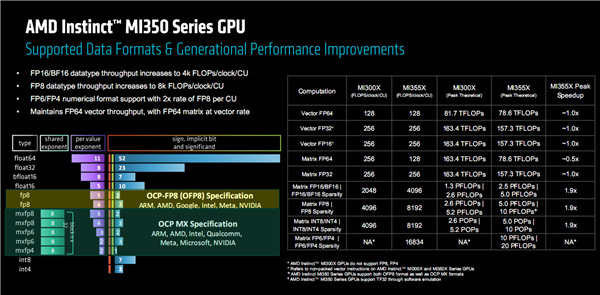

通过提升每个CU单元每时钟周期的性能,FP16、BF16、FP8、FP6、FP4的单位性能都得到了显著提升。

正因此如,MI355X在核心数更少的情况下,性能基本追上甚至超过了MI300X,其中矢量FP64、FP32、FP16和矩阵FP32下都基本一致,矩阵FP64下约为一半(单位性能也是一半),矩阵FP16/BF16、FP8、INT8/INT4下的稀疏性性能则几乎翻了一倍,还新增支持了矩阵FP6/FP4稀疏性。

可以看到,MIX350系列的性能并非全方位飞跃,有些数据格式下甚至更弱了,因为这代更注重支持更多更灵活的数据格式、单位性能的提升(类似提升IPC),以及对于AI训推更关键的矩阵稀疏性能。

当然更关键的是实际性能,官方宣称MI355X对比MI300X在不同AI大模型中的推理性能普遍提升了3倍甚至更多。

在AI助手/对话、内容创作、内容摘要、对话式AI等应用中,性能同样全面提升,最高幅度甚至超过4倍。

除了理论性能,大模型推理性能也处在同一水平,或者领先最多约30%,训练性能BF16/FP8预训练基本同一档次,FP8微调则有10%以上的领先。

MI350系列支持风冷、机架部署,其中风冷下最多64块并行,液冷时支持2U到5U,最多128块并行,也可以96块。

AMD声称,AMD致力于在5年内将AI计算平台的能效提升30倍,MI350系列最终做到了38倍!

下一步,从2024年到2030年,AMD将再次把AI系统的能效提升20倍,届时只需一台机架即可完成如今275台的工作,节省多达95%的能源。

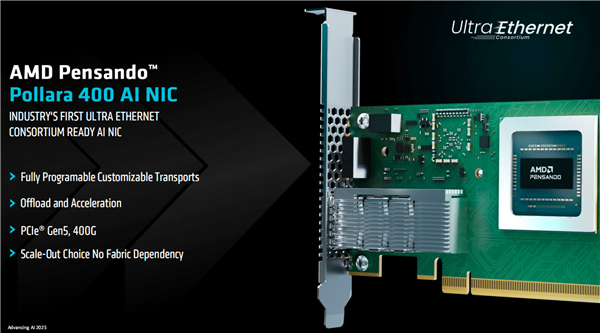

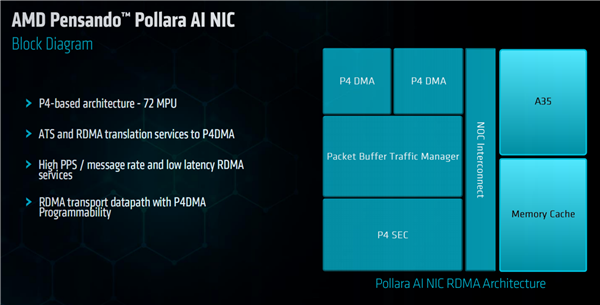

特别值得一提的是,作为AI加速系统平台的一部分,AMD此前还发布了一款超高性能网卡Pensando 400 AI(代号“Pollara”),首次与EPYC CPU、Instinct GPU一起组成完整的平台方案。

这是业界第一个符合超刚刚发布的以太网联盟(Ultra Ethernet)规范的网卡,支持PCIe 5.0,带宽达400G(40万兆),完全可编程可定制,可卸载和加速AI处理。

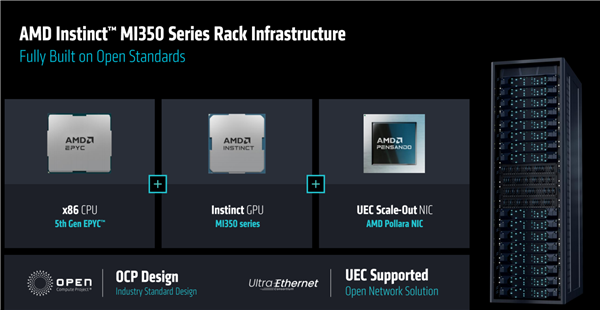

现在,AMD有了新一代全部基于自家技术和产品的AI加速系统平台级解决方案。

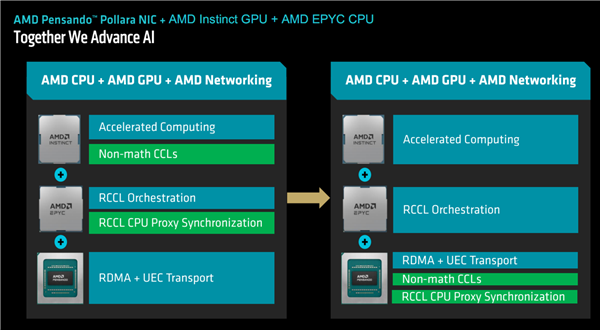

EPYC CPU处理器、Instinct GPU加速卡、Pensando网卡无缝配合,尤其是网卡可以卸载接手并高效处理CPU、GPU的部分工作,释放平台的最大性能潜力。

M350系列方案将从第三季度开始供应客户,可以看到各大OEM、ODM厂商基本都在名单之中了。

生态与应用合作伙伴方面,AMD Instinct的朋友圈正在快速扩大,全球十大AI企业中已经有七家用上了Instinct,包括微软、Meta、OpenAI、特斯拉、xAI、甲骨文等。

还有红帽、Mavell、Cohere、Astera Labs等等,甚至提到了华为,其正在与AMD探讨共同利用AMD平台打造开放的、可扩展的、高性价比的AI基础设施。

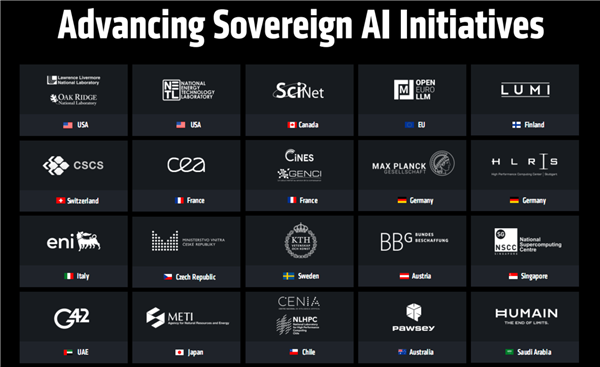

最后顺带一提,最新发布的TOP500超级计算机排行榜上,AMD EPYC+Instinct平台支撑了全球最快的两台超算,还在各个国家的不同项目中得到了广泛的部署。

位居榜首的是位于加州劳伦斯利弗莫尔国家实验室的El Capitan,采用第四代EPYC处理器、MI300A加速器的组合,拥有超过1100万个核心,最大性能达到1.742 EFlops(147.2亿亿次每秒)。

紧随其后的是田纳西州橡树岭国家实验室的Frontier,第三代EPYC、MI250X的组合,最大性能1.353EFlops(135.3亿亿次每秒)。mile米乐m6